- преамбула Сегодня я предлагаю билет, который призван побудить вас увидеть немного дальше, чем ссылки,...

- Подготовка данных

- Категоризация URL

- Анализ и выводы

- Сосредоточиться на 301 по категориям

- И что, мы их включаем?

- Анализ трафика соответствующих страниц

- Что бы сказал мой банкир?

- Что мы узнали?

- Как продолжить анализ?

- Что если я был взволнован ссылками?

- Конец истории

- спасибо

преамбула

Сегодня я предлагаю билет, который призван побудить вас увидеть немного дальше, чем ссылки, и проанализировать журналы сервера, а также другие источники данных (WA, WMT, CA ...) для SEO. Я предлагаю это, на конкретном примере, рассуждения, чтобы понять и решить проблему SEO на сайте. Я не претендую на то, чтобы овладеть искусством анализа журналов и отображать их в этой статье. Это не глобальный метод работы, потому что я привожу здесь пример точного анализа на сайте.

Наконец, знайте, что я ограничил эту статью единственными треками, которые непосредственно продвинули процесс. Поэтому его следует рассматривать как краткое изложение. Мы могли бы пойти гораздо дальше и собрать гораздо больше данных, но это не является целью.

Я признаю, что перед публикацией этой статьи я много колебался, потому что я скорее скажу немного о том, как я работаю, но определенно Орелиен Беррут , автор превосходного Htitipi.com, заставил меня задуматься. Я отреагировал на одну из его статей, сказав, что, как мне кажется, он сказал слишком много в публичном блоге, и он сказал, что это выгоднее, чем я думал. Давайте посмотрим, что :)

Начальная проблема

Я возьму случай с клиентом, чей трафик SEO снижается в течение некоторого времени. Он оставил мне след: он создал серию «контентных» страниц, единственной целью которых было на самом деле генерировать SEO-трафик. Страницы очень, очень оптимизированы и довольно бедны реальным и уникальным контентом (мы не всегда творим чудеса с вращением).

Проще говоря, это псевдо полностью автоматизированные целевые страницы SEO. Если они не генерируют чисто дублированный контент *, у них есть особенность ограниченного срока действия (информация, содержащаяся на этих страницах, имеет очень короткий срок действия). Как только информация устарела, страница просто стирается и «заменяется» перенаправлением 301 на страницу юниверса.

* Если Google хорошо справляется с анализом отпечатка текста, он готовится, поскольку они работают только на основе переменных в базе.

Я добровольно направил свою работу на исследование причины этого уменьшения прогрессивного трафика и, следовательно, на анализ этих страниц.

Подготовка данных

Извлечение полезных данных

Сначала я извлекал журналы - единственное действие ботов Google (набор ботов, который позже будет называться роботом Google, чтобы он был более удобочитаемым), потому что моя цель здесь - сосредоточиться на единственном поведении сканирования , Я ограничил анализ несколькими днями (с 13 до 19), чтобы быстро сгенерировать обработку данных, но я мог бы сделать это за более длительный период. Во многих случаях очень полезно не ограничивать свой анализ журналами, сгенерированными роботами, например, чтобы обнаружить страницы, генерирующие активность, без привлечения посещений SEO.

Вы также можете участвовать в увлекательных и полезных исследованиях, сопоставляя данные журналов с обходами сайтов, используя внутренний инструмент, данные веб-анализа и бизнес-данные. На сегодняшний день у меня нет достаточного инструмента, чтобы можно было его достичь, но жизнь долгая, и я не отчаиваюсь, чтобы найти :) Некоторые решения анализа журналов и обхода прибывают на рынок, ждут выхода из этих инструментов, прежде чем мы решим.

Категоризация URL

Чтобы правильно проанализировать сайт, необходимо категоризировать URL-адреса, например:

- форма - ([0-9]. +) \. html => Таблицы продуктов

- cat - (. *) - ([0-9]. +) \. html => Категории

- И т.д.

Задача не всегда очевидна: вы должны понимать и знать сайт, чтобы иметь возможность это сделать. Позже вы увидите, что очень полезно, если не обязательно, иметь возможность проводить конкретные действия анализа (что по-прежнему является целью маневра).

Со своей стороны я делюсь на два или три уровня. (Лист продукта // Вселенная // Район, например), чтобы можно было уточнить анализ, но, поскольку я делаю все вручную, это отнимает много времени.

Анализ и выводы

Количество просмотров Googlebot в день (в целом и за заголовок)

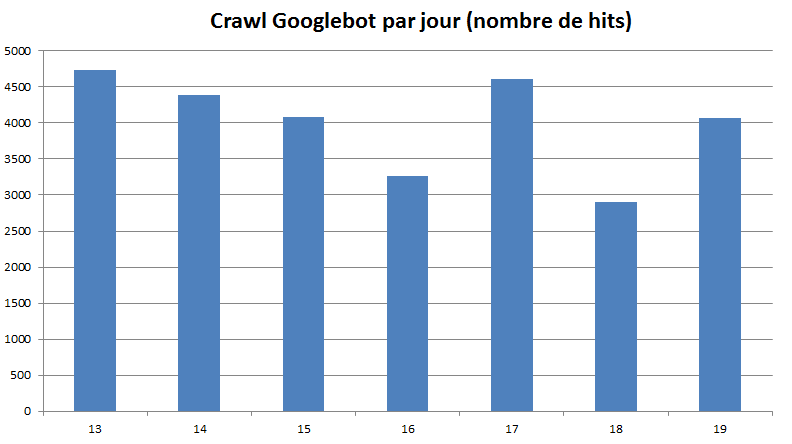

Моим первым шагом было отметить количество посещений (не уникальных), генерируемых Google на сайте каждый день (здесь отфильтровано только 200). Мы получаем в среднем примерно 4000 просмотров за 200 в день. Мне пришлось вернуться за месяц до запуска этих известных страниц SEO, но журналы были недоступны.

В этом отчете ничего особенного не говорится, но полезно следить за ним в течение длительных периодов времени, чтобы увидеть тенденции: вверх, хорошая работа, вниз, тревога, если нет немедленного оправдания!

Количество посещений Google Bot в день

Несколько строк выше я рассказал вам о категоризации URL. Именно здесь эти данные оказываются незаменимыми, поскольку они позволяют создать более полезный график: распределение сканирования по категориям. К сожалению, я не сохранил сгенерированный график. Мы могли видеть, что большая часть сканирования сайта (68%) выполняется на ... страницах, которые клиент создал для SEO и которые с самого начала предупредили меня. Вот тогда.

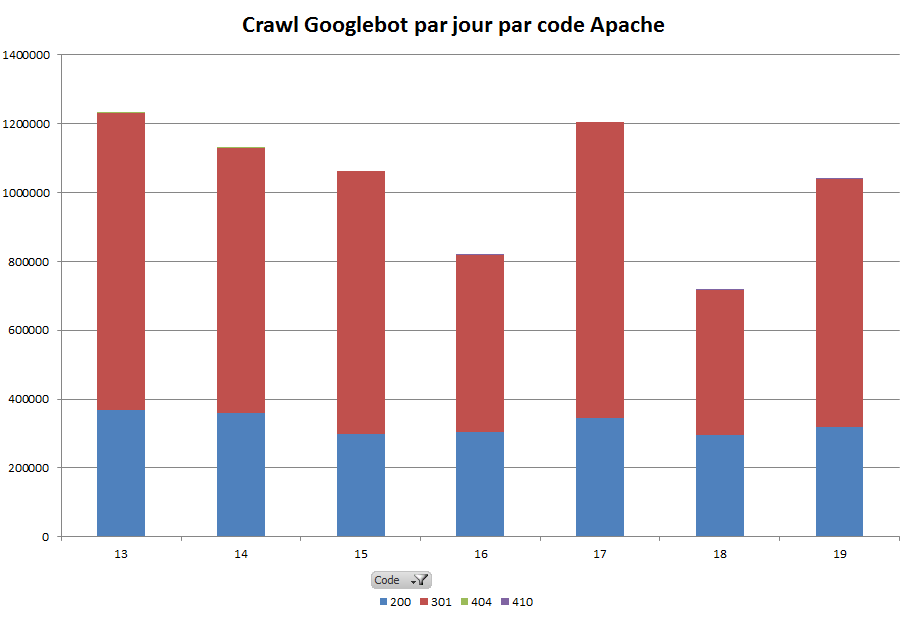

Если вы не можете представить этот график, посмотрите на следующее, очень интересное. Это позволяет сравнивать различные типы кодов, с которыми сталкиваются роботы в течение того же периода. Наблюдение назидательно:

Количество хитов в день на заголовок

Мы сразу видим, что, если кажется, что сайт очень хорошо управляет своими ссылками (мало или нет 404), заголовок 301 чрезвычайно присутствует. Их более 200! Это первый раз, когда я вижу что-то подобное в масштабе сайта.

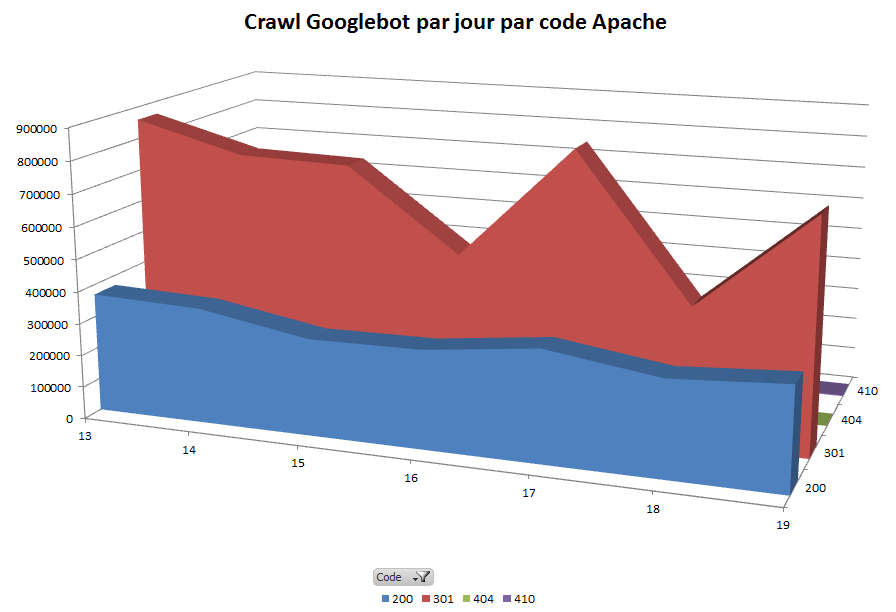

Чтобы лучше измерить ситуацию, я сгенерировал другое представление, на этот раз в 3D, которое, по моему мнению, хорошо выражает озабоченность (лично я нахожу это более выразительным):

Количество хитов в день по 3D заголовку

Очевидно, что где-то есть проблема, и вам нужно проанализировать, что происходит. Google съедает почти в 2 раза больше, чем 301, чем 200 ... все время зная, что следование 301 приводит к 200 в конце. Давайте посмотрим на эти 301, чтобы увидеть, откуда они берутся.

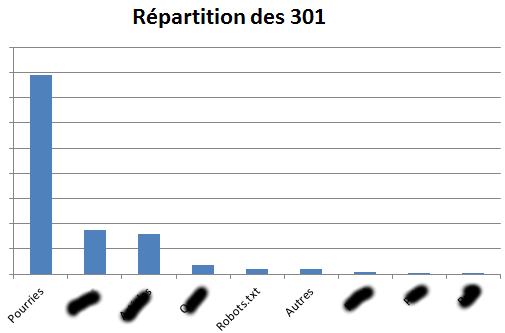

Сосредоточиться на 301 по категориям

Здесь снова категоризация URL будет служить нам.

301 за тип страницы

У меня есть скрытые названия категорий URL, представьте, что за черными пирогами стоят:

- Страницы вселенной

- Категории / радиус страницы

- CMS страницы

- SEO Landing

- И т.д.

Название «Pourries», я просто дал его этим страницам, созданным клиентом, чтобы повысить SEO своего сайта. До анализа логов я совсем не думал, что одной из причин их контрпроизводительности будет генерация тонн 301. Я положил палец на что-то интересное.

Наши вонючие страницы, в дополнение к монополизации сканирования на сайте, генерируют 301 переадресацию.

И что, мы их включаем?

Собираемся ли мы напрямую вырезать какую-либо внутреннюю ссылку на эти страницы и отключить сканирование? Не слишком быстро! Перед этим необходимо задать правильные вопросы (неисчерпывающий список):

- Эти страницы интересны посетителям?

- Эти страницы приносят трафик?

- Эти страницы генерируют бизнес?

- Питают ли эти страницы структуру Page Rank снаружи?

- Эти страницы толкают ключевые страницы внутри?

- ...

Я просто собираюсь заинтересоваться здесь пунктами 2 и 3.

Анализ трафика соответствующих страниц

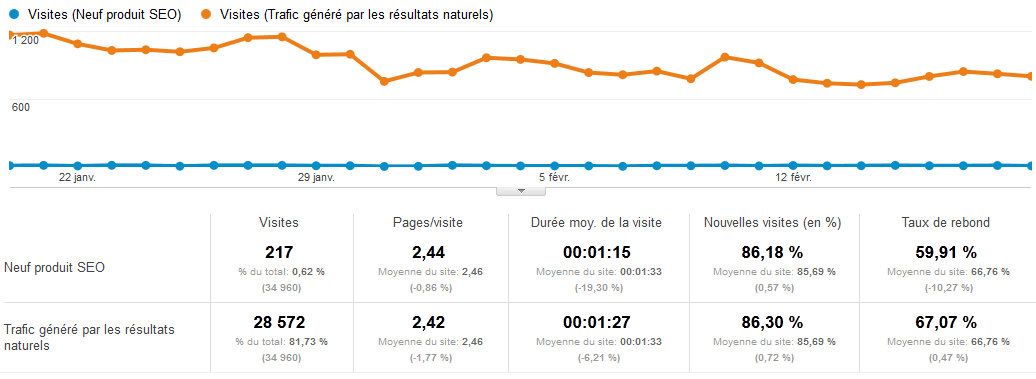

Я основан на простом отчете Google Analytics Content> Destination pages в глобальном сегменте SEO (бренд и не бренд). Если бы у меня были полные журналы, я также мог бы очень легко получить эту информацию с точки зрения количества посещений.

SEO трафик оскорбительных страниц

Уч. Давайте подведем итоги. Волшебные страницы должны повысить SEO:

- Потребляйте 68% ежедневного сканирования

- 44% попаданий приводят к 301 переадресации, указывающей на другие разделы сайта

- Генерировать ... 0,62% от общего SEO-трафика сайта

Однако мы видим, что количество страниц за посещение, средняя продолжительность посещения и показатель отказов не синхронизированы с остальной частью сайта (даже если статистика плохая).

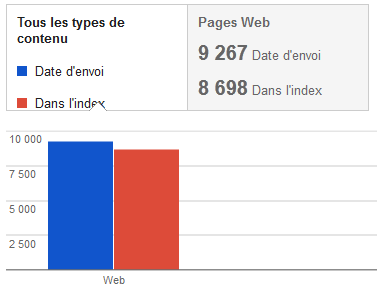

Какова скорость индексации этих страниц? Многие сканируют, мало трафика, страницы еще оптимизированы. Интересно, если они ... проиндексированы! И если да, то они преимущественно? Вот что Инструменты Веб-мастера говорят для этих страниц:

Скорость индексации

На первый взгляд, Google индексирует 93% этих страниц, но в нашей ситуации эта цифра ничего не значит. Что должно быть сделано, это:

- чтобы знать, почему 100% не достигается (учитывая размер сайта, это должно быть так)

- узнать количество уникальных URL-адресов, сканируемых каждый день для этой типологии страниц

- знать, сколько времени прошло между сканированием и индексацией этих страниц

- удалите результаты поиска в момент времени T и сравните список проиндексированных URL со списком URL, присутствующих в arbo в тот же день

- ...

Таким образом, мы бы знали, сможет ли робот каждый день сканировать, индексировать и ранжировать все эти страницы. В настоящее время это далеко не так.

Однако мы все же должны проанализировать один момент: эти страницы являются качественными или стимулируют пользователя?

Что бы сказал мой банкир?

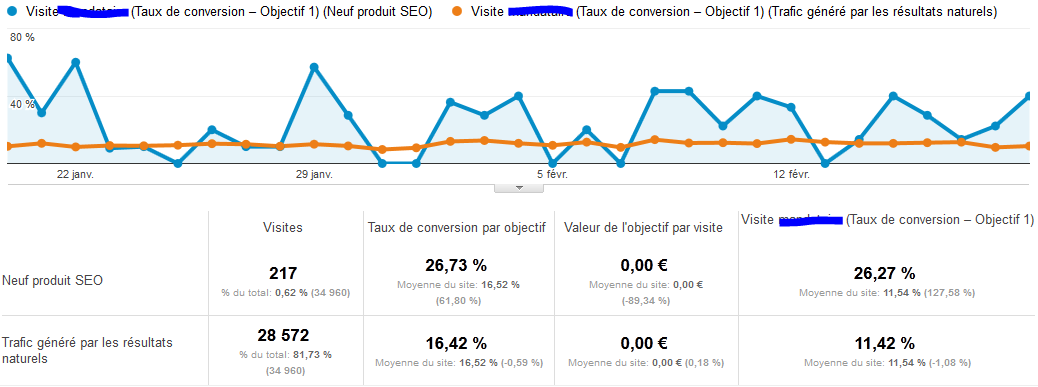

Эти страницы генерируют бизнес? В конце концов, мы управляем SEO, мы работаем, тратим время, но цель состоит в том, чтобы сделать чистую прибыль. Если не удастся продвинуть анализ до конца, посмотрите, не заинтересованы ли эти страницы в конверсии на сайте:

Анализ конверсии

Коэффициент конверсии на этих страницах более чем в два раза выше, чем у всего сайта в сегменте SEO. Это подтверждает заинтересованность этих страниц для посетителя и для конверсии. Вот кое-что, чтобы питать размышления о том, что можно сделать.

Что мы узнали?

Мы обнаружили, что эти страницы, которые должны быть магическими, ежедневно занимают значительную часть сканирования сайта, что большинство посещений роботов приводят к 301, и в то же время эти страницы генерируют очень мало трафика. Однако трафик, который там падает, квалифицирован и помогает с конвертацией.

Мы также узнали, что мы не получили бы эти данные, делая отчеты о позиционировании, проверяя ссылки, сканируя сайт или даже анализируя статистику.

Что-то подсказывает мне, что было бы лучше, сначала и прежде чем подумать об их удалении, попытайтесь выяснить, как лучше выделить эти страницы и как сделать их более совместимыми с SEO.

В конце концов, я думаю, что все приводит к тому, что:

- Либо эти страницы имеют короткий срок жизни. Если бы они были более устойчивыми, было бы намного меньше, чем 301, было бы меньше сканирования (мы могли бы лучше оптимизировать его), и все было бы проиндексировано

- Либо они не получают достаточно Page Rank

Как продолжить анализ?

В этом очень конкретном и точном примере мы увидели, что анализ журналов в сочетании с анализом других источников данных действительно может помочь обнаружить и решить проблемы, связанные с SEO на сайте.

Анализ еще далек от завершения, и мы, безусловно, должны следовать следующим трекам:

- Чтобы подтолкнуть анализ:

- Хотите знать, почему эти страницы не получают интересные позиции в поисковой выдаче?

- Посвятите хиты на эти 301, чтобы знать, затрагивает ли проблема небольшое количество страниц или все

- Проверьте рейтинг страниц этих страниц и ссылки, указывающие на них (и сделайте необходимые выводы, я не говорю больше)

- Анализировать частоту сканирования в день на вонючих страницах

- ...

- Чтобы решить проблему:

- Сделайте эти страницы более устойчивыми

- Улучшите внутреннюю сетку, чтобы повысить рейтинг страниц на этих страницах и помочь им перераспределить больше

- Отправить больше Внешние страницы рейтинга на эти страницы (ссылки)

- Улучшение частоты сканирования на вонючих страницах

- ...

Что если я был взволнован ссылками?

Если бы я никогда не видел журналы, что бы я сделал? Я бы сделал те же выводы о трафике и конверсии, и я бы сосредоточил всю свою энергию на создании внешних ссылок на эту типологию вонючих страниц. Мне, конечно, удалось бы получить немного трафика, но я бы не решил проблемы, связанные с малым сроком службы страниц, и, вероятно, не мог бы увидеть, что они потенциально наказывают весь сайт.

На самом деле, я думаю, что наиболее эффективным будет сначала найти решение проблемы, а затем привнести необходимые связи.

Конец истории

Проанализируйте ваши логи! Как и я, сходите с ума от своих коллег, которые не работают в SEO и верят, что вы видите «общение с Google», когда они проходят перед вашим экраном, заполненным строками логов. Анализируйте, анализируйте, пытайтесь понять Google.

Это требует времени, поначалу это довольно удручает (мы думали, что у нас есть лучший сайт, а реальность совсем другая), это требует энергии и страсти, но когда мы осваиваем основы, так как это едва В моем случае мы весело проводим время.

Вам понравилась эта статья? Может быть, ваши контакты оценят это! Не стесняйтесь в Twitter и Plusser!

Любые комментарии будут оценены до тех пор, пока не будет «измельчить обратную ссылку» (и он будет содержать слово kracaplouf), чтобы доказать, что вы прочитали статью, по крайней мере, до здесь. Я обнаружил этот трюк благодаря Сильвен Фуйо Он же Новисео, который использовал этот трюк в одной из своих статей. Я нашел это очень умным. В любом случае участвуйте в этом посте, несите свое видение.

Спасибо, что читаете меня, с нетерпением ждем ваших реакций;)

спасибо

Спасибо, спасибо. Они на самом деле не имеют прямой связи с этой статьей, но я хотел их где-то разместить. Я хочу сердечно поблагодарить двух людей, которые непреднамеренно, не зная этого, не намереваясь это, дали реальное значение этому виду анализа, который я иногда делал для SEO моих сайтов или моих клиентов ,

До их встречи, которая длилась не более получаса, я делал это совершенно умело и думал, что я немного не вписываюсь в сферу моей работы. Я думал, что я был далеко от сообщества SEO, одержимого связыванием. Я думаю, конечно, много хороших внешних ссылок, и я знаю, насколько они эффективны в стратегии SEO, но на хорошей основе.

Когда я встретил этих двух людей, я узнал, что некоторые компании извлекают огромную выгоду (SEO) из работы над этой осью SEO. Конечно, эта команда мечты должна делать это с профессионализмом и качеством совершенно другого уровня, но это заставило меня хотеть профессионализировать свой подход. В то же время я узнал, что «белая шляпа» может быть ультра технической, ультра качественной и может потребовать большого опыта.

Благодаря Жан-Бенуа Моингт и Медхи Моро произнести несколько волшебных фраз, которые пробудили мое любопытство.

Подписаться на канал RSS лента | Вы можете пропустить до конца и оставить отзыв. Пинг в настоящее время не разрешен.

Что мы узнали?Как продолжить анализ?

Что если я был взволнован ссылками?

И что, мы их включаем?

Собираемся ли мы напрямую вырезать какую-либо внутреннюю ссылку на эти страницы и отключить сканирование?

Эти страницы приносят трафик?

Эти страницы генерируют бизнес?

Питают ли эти страницы структуру Page Rank снаружи?

Эти страницы толкают ключевые страницы внутри?

Какова скорость индексации этих страниц?